09/08/22

Quando as linhas de comunicação estão abertas, agentes individuais, como robôs ou drones, podem trabalhar juntos para colaborar e concluir uma tarefa. Mas e se eles não estiverem equipados com o hardware certo ou os sinais estiverem bloqueados, impossibilitando a comunicação?

Os pesquisadores da Universidade de Illinois Urbana-Champaign desenvolveram um método para treinar vários agentes para trabalharem juntos usando aprendizado de reforço multiagente, um tipo de inteligência artificial.

“É mais fácil quando os agentes podem conversar uns com os outros”, disse Huy Tran, engenheiro aeroespacial de Illinois. “Mas queríamos fazer isso de forma descentralizada, o que significa que eles não conversam entre si. Também nos concentramos em situações em que não é óbvio quais deveriam ser as diferentes funções ou trabalhos dos agentes”.

Tran disse que esse cenário é muito mais complexo e um problema mais difícil porque não está claro o que um agente deve fazer em relação a outro agente. “A questão interessante é como aprendemos a realizar uma tarefa juntos ao longo do tempo”, disse Tran.

Tran e seus colaboradores usaram o aprendizado de máquina (machine learning) para resolver esse problema criando uma função de utilidade que informa ao agente quando ele está fazendo algo útil ou bom para a equipe.

“Com os gols da equipe, é difícil saber quem contribuiu para a vitória”, disse ele. “Desenvolvemos uma técnica de aprendizado de máquina que nos permite identificar quando um agente individual contribui para o objetivo global da equipe. Se você olhar em termos de esportes, um jogador de futebol pode marcar, mas também queremos saber sobre ações de outros companheiros de equipe que levaram ao gol, como assistências. É difícil entender esses efeitos retardados”.

Os algoritmos desenvolvidos pelos pesquisadores também podem identificar quando um agente ou robô está fazendo algo que não contribui para o objetivo. “Não é tanto que o robô escolheu fazer algo errado, apenas algo que não é útil para o objetivo final”.

Eles testaram seus algoritmos usando jogos simulados como Capture the Flag e StarCraft, um popular jogo de computador. “StarCraft pode ser um pouco mais imprevisível – ficamos empolgados em ver nosso método funcionar bem nesse ambiente também”.

Tran disse que esse tipo de algoritmo é aplicável a muitas situações da vida real, como vigilância militar, robôs trabalhando juntos em um armazém, controle de semáforos, veículos autônomos coordenando entregas ou controlando uma rede de energia elétrica.

Tran disse que Seung Hyun Kim fez a maior parte da teoria por trás da ideia quando era um estudante de graduação de Engenharia Mecânica, com Neale Van Stralen, um estudante aeroespacial, ajudando na implementação. Tran e Girish Chowdhary aconselharam ambos os alunos. O trabalho foi recentemente apresentado à comunidade de IA na conferência revisada por pares de Agentes Autônomos e Sistemas Multiagentes.

O estudo, “Disentangling Successor Features for Coordination in Multi-agent Reinforcement Learning”, escrito por Seung Hyun Kim, Neale Van Stralen, Girish Chowdhary e Huy Tran, aparece nos Anais da 21ª Conferência Internacional sobre Agentes Autônomos e Sistemas Multiagentes realizada em maio de 2022.

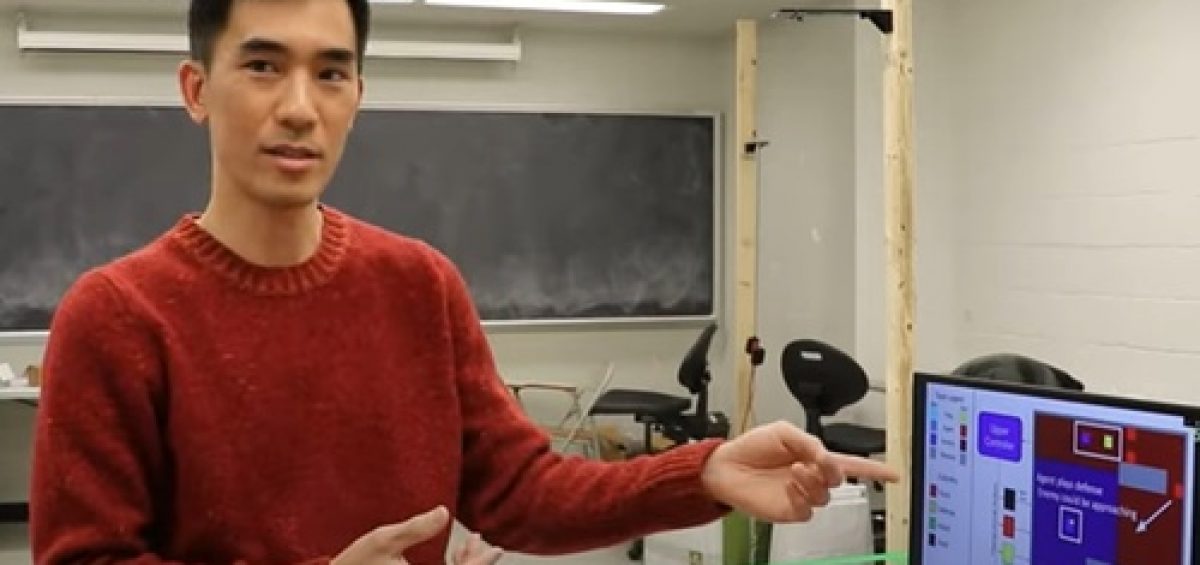

Confira o vídeo (em inglês) em que Tran descreve como ele usou o modelo baseado no jogo Capture the Flag para desenvolver a nova visão do aprendizado por reforço profundo que ajuda os robôs a avaliar seu próximo movimento:

Fonte: CIMM

Deixe um Comentário